تا همین چند سال پیش، استفاده از هوش مصنوعی مولد (Generative AI) به معنای اتصال به سرورهای غولپیکر OpenAI یا Google و پرداخت هزینههای اشتراک بود. اما در سال ۲۰۲۵، ورق برگشته است! با بهینهسازی مدلهای زبانی (LLM) و قدرتمندتر شدن سختافزارهای خانگی، اکنون میتوانید هوشهای مصنوعی قدرتمندی مثل Llama 3 (متا) یا Mistral را کاملاً آفلاین، خصوصی و رایگان روی لپتاپ یا PC خود اجرا کنید. در این آموزش تخصصی از آلفاتک، روش راهاندازی یک آزمایشگاه هوش مصنوعی شخصی را یاد خواهید گرفت.

فهرست مطالب اجرای هوش مصنوعی روی کامپیوتر

- چرا باید LLM را لوکال (Local) اجرا کنیم؟

- پیشنیازهای سختافزاری (VRAM مهمتر از همه)

- مفهوم حیاتی کوانتایزیشن (Quantization) و فایلهای GGUF

- روش اول: استفاده از LM Studio (ساده و گرافیکی)

- روش دوم: استفاده از Ollama (مخصوص برنامهنویسان)

- جدول مقایسه سرعت اجرا روی GPU vs CPU

- سوالات متداول

- سخن پایانی

چرا باید LLM را لوکال (Local) اجرا کنیم؟

اجرای مدل زبانی روی سختافزار شخصی (Local Inference) سه مزیت حیاتی نسبت به ChatGPT یا Claude دارد:

- حریم خصوصی (Privacy): هیچ دادهای از کامپیوتر شما خارج نمیشود. برای شرکتهایی که روی کدهای محرمانه یا دادههای مالی کار میکنند، این تنها راه امن استفاده از AI است.

- هزینه صفر: پس از خرید سختافزار، استفاده از مدلها کاملاً رایگان است.

- بدون سانسور (Uncensored): شما میتوانید مدلهایی را دانلود کنید که محدودیتهای اخلاقی سختگیرانه شرکتهای بزرگ را ندارند (مناسب برای داستاننویسی یا تست امنیت).

پیشنیازهای سختافزاری (VRAM مهمتر از همه)

برای اجرای روان مدلها، “حافظه گرافیکی” (VRAM) حرف اول را میزند. اگر مدل در VRAM جا نشود، سیستم از RAM اصلی استفاده میکند که سرعت را به شدت کاهش میدهد.

- حداقل: ۸ گیگابایت VRAM (اجرای مدلهای 7B و 8B با سرعت خوب).

- پیشنهادی: ۱۶ تا ۲۴ گیگابایت VRAM (اجرای مدلهای سنگین Llama-3-70B با کوانتایزیشن).

- حافظه رم (RAM): حداقل ۱۶ گیگابایت (اگر کارت گرافیک قوی ندارید، ۳۲ گیگابایت رم DDR5 برای اجرای روی CPU الزامی است).

مفهوم حیاتی کوانتایزیشن (Quantization) و فایلهای GGUF

یک مدل اصلی مثل Llama 3 با دقت ۱۶ بیت (FP16) حجمی حدود ۱۵ گیگابایت دارد. اما تکنیکی به نام Quantization وجود دارد که دقت وزنها را به ۴ بیت یا ۸ بیت کاهش میدهد بدون اینکه هوش مدل افت شدیدی پیدا کند.

فرمت استاندارد فعلی برای اجرای لوکال، GGUF است. هنگام دانلود مدلها با پسوندهایی مثل Q4_K_M یا Q8_0 مواجه میشوید:

- Q4_K_M: متعادلترین نسخه (حجم کم، سرعت بالا، دقت قابل قبول).

- Q8_0: بالاترین دقت، حجم بالا (نیازمند سختافزار قوی).

روش اول: استفاده از LM Studio (ساده و گرافیکی)

اگر علاقهای به کدنویسی و ترمینال ندارید، LM Studio بهترین گزینه است.

- نرمافزار را از سایت رسمی دانلود و نصب کنید.

- در نوار جستجو (Search)، نام مدل دلخواه مثلاً

Llama 3یاMistralرا تایپ کنید. - از پنل سمت راست، بر اساس قدرت سختافزار خود، یکی از فایلهای GGUF (ترجیحاً Q4) را دانلود کنید.

- به تب Chat بروید، مدل را انتخاب کنید (Load) و شروع به گفتگو کنید.

نکته: در تنظیمات سمت راست، گزینه GPU Offload را روی Max قرار دهید تا تمام بار پردازشی روی کارت گرافیک بیفتد.

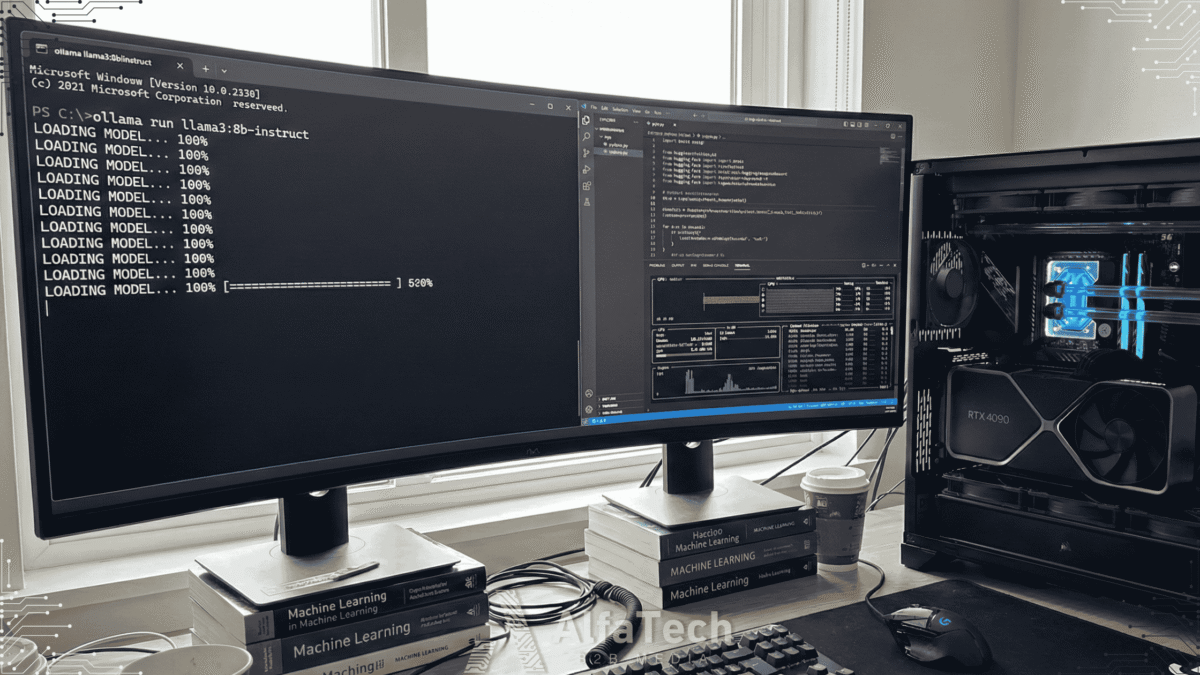

روش دوم: استفاده از Ollama (مخصوص برنامهنویسان)

ابزار Ollama خط فرمانی (CLI) است و اجازه میدهد مدلها را مثل داکر (Docker) اجرا کنید و حتی از طریق API به کدهای پایتون متصل کنید.

مراحل نصب سریع:

- دانلود و نصب Ollama.

- باز کردن CMD یا Terminal.

- تایپ دستور:

ollama run llama3

سیستم به صورت خودکار مدل را دانلود و اجرا میکند. این روش برای توسعهدهندگانی که میخواهند چتبات اختصاصی بسازند عالی است.

جدول مقایسه سرعت اجرا روی GPU vs CPU

تفاوت سرعت (Token per Second) در اجرای مدل Llama-3-8B بر روی سختافزارهای مختلف:

| سختافزار | سرعت (توکن بر ثانیه) | تجربه کاربری |

|---|---|---|

| NVIDIA RTX 4090 (24GB) | 110 t/s | سریعتر از خواندن انسان (آنی) |

| NVIDIA RTX 3060 (12GB) | 45 t/s | بسیار روان و عالی |

| Apple M2 Pro (MacBook) | 30 t/s | خوب و کاربردی |

| CPU Intel Core i7 (DDR4) | 3 – 5 t/s | کند (کلمه به کلمه تایپ میشود) |

سوالات متداول اجرای هوش مصنوعی روی کامپیوتر

۱. آیا مدلهای لوکال از زبان فارسی پشتیبانی میکنند؟

مدلهای اصلی مثل Llama 3 فارسی را میفهمند اما در تولید متن فارسی کمی ضعف دارند. پیشنهاد میشود از مدلهای Fine-tune شده مثل Dorous یا نسخه دستکاری شده Command-R برای زبان فارسی استفاده کنید.

۲. آیا میتوانم مدلهای لوکال را به اینترنت وصل کنم؟

به صورت پیشفرض خیر، مدلها فقط دانش ذخیره شده خود را دارند. اما با ابزارهایی مثل LangChain یا قابلیتهای جدید LM Studio میتوانید امکان جستجو در وب را به آنها اضافه کنید.

۳. بهترین مدل برای برنامهنویسی (Coding) چیست؟

در حال حاضر مدلهای CodeLlama و DeepSeek Coder عملکردی نزدیک به GPT-4 در نوشتن کد دارند و کاملاً رایگان هستند.

سخن پایانی اجرای هوش مصنوعی روی کامپیوتر

اجرای هوش مصنوعی روی کامپیوتر شخصی، حس مالکیت و قدرت را به شما باز میگرداند. دیگر نگران قطعی API، تحریم IP یا نشت اطلاعات محرمانه نخواهید بود. دنیای مدلهای Open Source هر روز در حال پیشرفت است و امروز بهترین زمان برای پیوستن به این جریان است.

برای آشنایی با جدیدترین مدلهای منتشر شده و آموزشهای پیشرفته برنامهنویسی هوش مصنوعی، بخش نرمافزار و AI رسانه آلفاتک را دنبال کنید.