دنیای سختافزار بار دیگر لرزید. پس از ماهها انتظار و پیشنمایشهای هیجانانگیز، کمپانی انویدیا (Nvidia) سرانجام عرضه انبوه معماری جدید خود موسوم به Blackwell را برای غولهای فناوری (Hyperscalers) آغاز کرد. این تراشهها که قرار است موتور محرک هوش مصنوعی در سال ۲۰۲۵ باشند، تنها یک ارتقای سرعت ساده نیستند؛ بلکه استانداردهای مهندسی دیتاسنتر را به چالش کشیدهاند. تراکم ترانزیستور و حرارت تولیدی این هیولاها به قدری بالاست که عملاً استفاده از سیستمهای سنتی خنککننده هوا (Air Cooling) را غیرممکن میکند. رسانه آلفاتک در این گزارش اختصاصی، مشخصات فنی سری B200 و تأثیر آن بر آینده زیرساختهای ابری جهان را بررسی میکند.

فهرست مطالب

- بلکول (Blackwell) چیست؟ ۲۰۸ میلیارد ترانزیستور در یک پکیج

- چالش حرارتی؛ چرا فنهای بادی دیگر جواب نمیدهند؟

- جدول مقایسه غولها: Hopper H100 در برابر Blackwell B200

- بحران انرژی؛ اتحاد مایکروسافت و آمازون با نیروگاههای هستهای

- تاثیر بر بازار سرور (HPE, Dell, Supermicro)

- سوالات متداول

- سخن پایانی

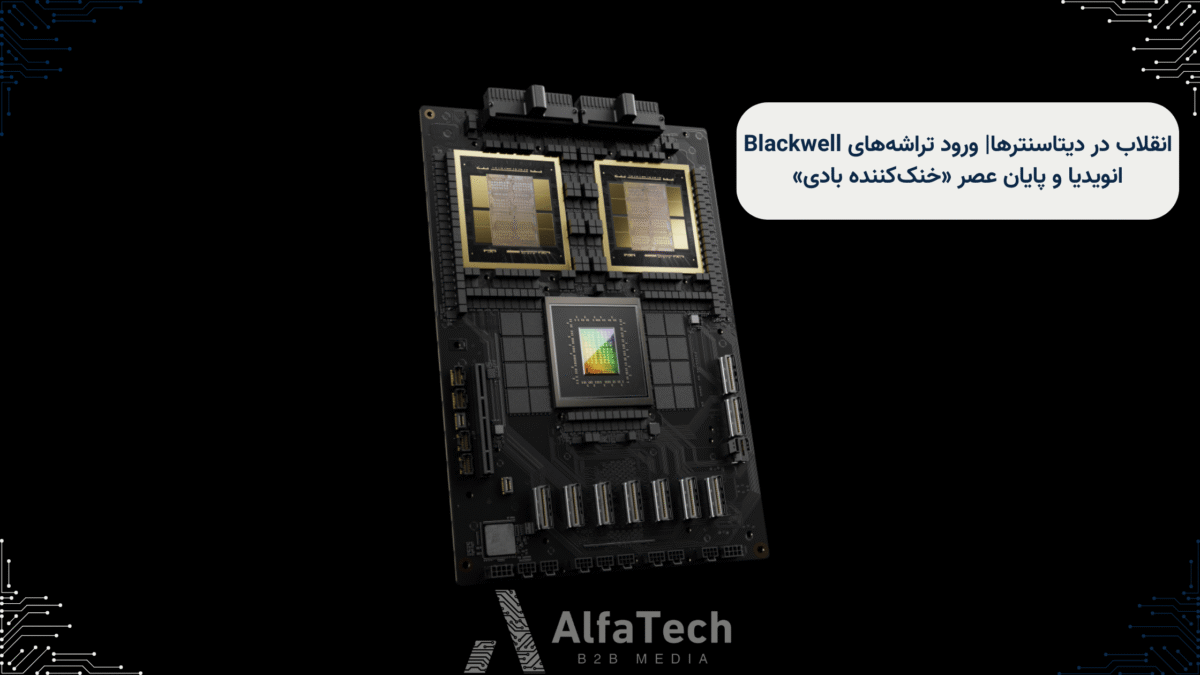

بلکول (Blackwell) چیست؟ ۲۰۸ میلیارد ترانزیستور در یک پکیج

جنسن هوانگ، مدیرعامل انویدیا، این تراشه را «موتوری برای انقلاب صنعتی جدید» نامیده است. پردازنده گرافیکی B200 از معماری چیپلت (Chiplet) استفاده میکند؛ به این معنی که دو تراشه سیلیکونی عظیم با سرعت ۱۰ ترابایت بر ثانیه به هم متصل شدهاند و سیستمعامل آنها را به عنوان یک تراشه واحد میشناسد.

نتیجه این معماری، قدرت پردازشی خیرهکنندهای است که آموزش مدلهای زبانی بزرگ (LLM) با تریلیونها پارامتر (مانند GPT-5) را تا ۴ برابر سریعتر و با ۲۵ برابر بهرهوری انرژی بیشتر نسبت به نسل قبل ممکن میسازد.

چالش حرارتی؛ چرا فنهای بادی دیگر جواب نمیدهند؟

این قدرت عظیم، هزینهای دارد: گرما. توان طراحی حرارتی (TDP) هر ماژول GB200 به حدود ۱۲۰۰ وات (و در کل رک تا ۱۲۰ کیلووات) میرسد. دیتاسنترهای سنتی که با جریان هوای سرد (CRAC) خنک میشدند، توانایی دفع این حجم از حرارت را ندارند.

به همین دلیل، سال ۲۰۲۵ نقطه عطفی برای تکنولوژی خنککننده مایع مستقیم (Direct Liquid Cooling – DLC) است. در این روش، مایع خنککننده مستقیماً روی چیپها جریان مییابد. شرکتهای سازنده دیتاسنتر اکنون مجبورند تمام زیرساختهای لولهکشی و پمپاژ خود را برای میزبانی از Blackwell تغییر دهند.

جدول مقایسه غولها: Hopper H100 در برابر Blackwell B200

تفاوت نسل پرچمدار ۲۰۲۳ با پرچمدار ۲۰۲۵ در جدول زیر مشهود است:

| مشخصات | Nvidia H100 (Hopper) | Nvidia B200 (Blackwell) | میزان پیشرفت |

|---|---|---|---|

| تعداد ترانزیستور | ۸۰ میلیارد | ۲۰۸ میلیارد | ۲.۶ برابر |

| حافظه (HBM3e) | ۸۰ گیگابایت | ۱۹۲ گیگابایت | ۲.۴ برابر |

| عملکرد هوش مصنوعی (FP4) | ۴ پتافلاپس | ۲۰ پتافلاپس | ۵ برابر |

| توان مصرفی (TDP) | ۷۰۰ وات | ۱۰۰۰ تا ۱۲۰۰ وات | افزایش مصرف |

بحران انرژی؛ اتحاد مایکروسافت و آمازون با نیروگاههای هستهای

نصب هزاران عدد از این چیپها، نیازمند نیروگاهی اختصاصی است. گزارشها نشان میدهد که مصرف برق دیتاسنترهای هوش مصنوعی در سال ۲۰۲۵ از مصرف برق کل برخی کشورهای کوچک فراتر میرود. در واکنشی استراتژیک، غولهای فناوری مثل مایکروسافت و آمازون قراردادهای بلندمدتی با نیروگاههای هستهای بستهاند تا برق پایدار و بدون کربن برای این هیولاهای پردازشی تامین کنند. این نشان میدهد که گلوگاه بعدی تکنولوژی، «تراشه» نیست، بلکه «انرژی» است.

تاثیر بر بازار سرور (HPE, Dell, Supermicro)

ورود Blackwell باعث رونق بیسابقه در بازار سازندگان سرور شده است. شرکتهایی مثل Dell و Supermicro در حال رقابت برای طراحی رکهایی هستند که بتوانند وزن سنگین و لولهکشی پیچیده سیستمهای مایع را تحمل کنند. پیشبینی میشود قیمت سرورهای نسل قبل (H100) در نیمه دوم سال ۲۰۲۵ کاهش یابد که فرصتی عالی برای شرکتهای کوچکتر جهت نوسازی زیرساخت خواهد بود.

سوالات متداول

۱. قیمت هر چیپ B200 چقدر است؟

انویدیا قیمت رسمی تکفروشی را اعلام نمیکند، اما تحلیلگران قیمت هر واحد GPU را بین ۳۰ تا ۴۰ هزار دلار تخمین میزنند. البته این چیپها معمولاً در قالب سرورهای کامل (مانند DGX) فروخته میشوند که قیمتهایی چند میلیون دلاری دارند.

۲. آیا این تراشهها برای گیمینگ هم استفاده میشوند؟

خیر، سری Blackwell B200 مخصوص دیتاسنتر و محاسبات AI است. کارتهای گرافیک گیمینگ (سری RTX 50) با معماری مشابه اما مقیاس کوچکتر و مصرف برق کمتر عرضه خواهند شد.

۳. چرا رم (Memory) در این چیپها اینقدر مهم است؟

مدلهای هوش مصنوعی (مثل GPT) حجم بسیار زیادی دارند و باید در حافظه رم بارگذاری شوند. حافظه ۱۹۲ گیگابایتی B200 اجازه میدهد مدلهای بزرگتر و باهوشتر، سریعتر اجرا شوند.

سخن پایانی

عرضه Blackwell تنها یک خبر سختافزاری نیست؛ بلکه زنگ هشداری برای تغییر کامل اکوسیستم زیرساخت است. دیتاسنترهای آینده، ساکتتر (بدون فنهای پرصدا) اما داغتر و تشنهتر به انرژی خواهند بود. برای مدیران IT، پیام روشن است: زیرساختهای سنتی توان میزبانی از هوش مصنوعی نسل بعدی را ندارند. برای پیگیری آخرین اخبار سختافزار سرور و تکنولوژیهای کولینگ، بخش اخبار جهانی آلفاتک را دنبال کنید.